Inteligencia artificial: Rompiendo los esquemas

Parte Uno

¿Serán pronto las máquinas más listas que los humanos? Un experto en IA habla sobre el estado actual de la tecnología, hacia dónde apunta y qué debería preocuparnos al respecto.

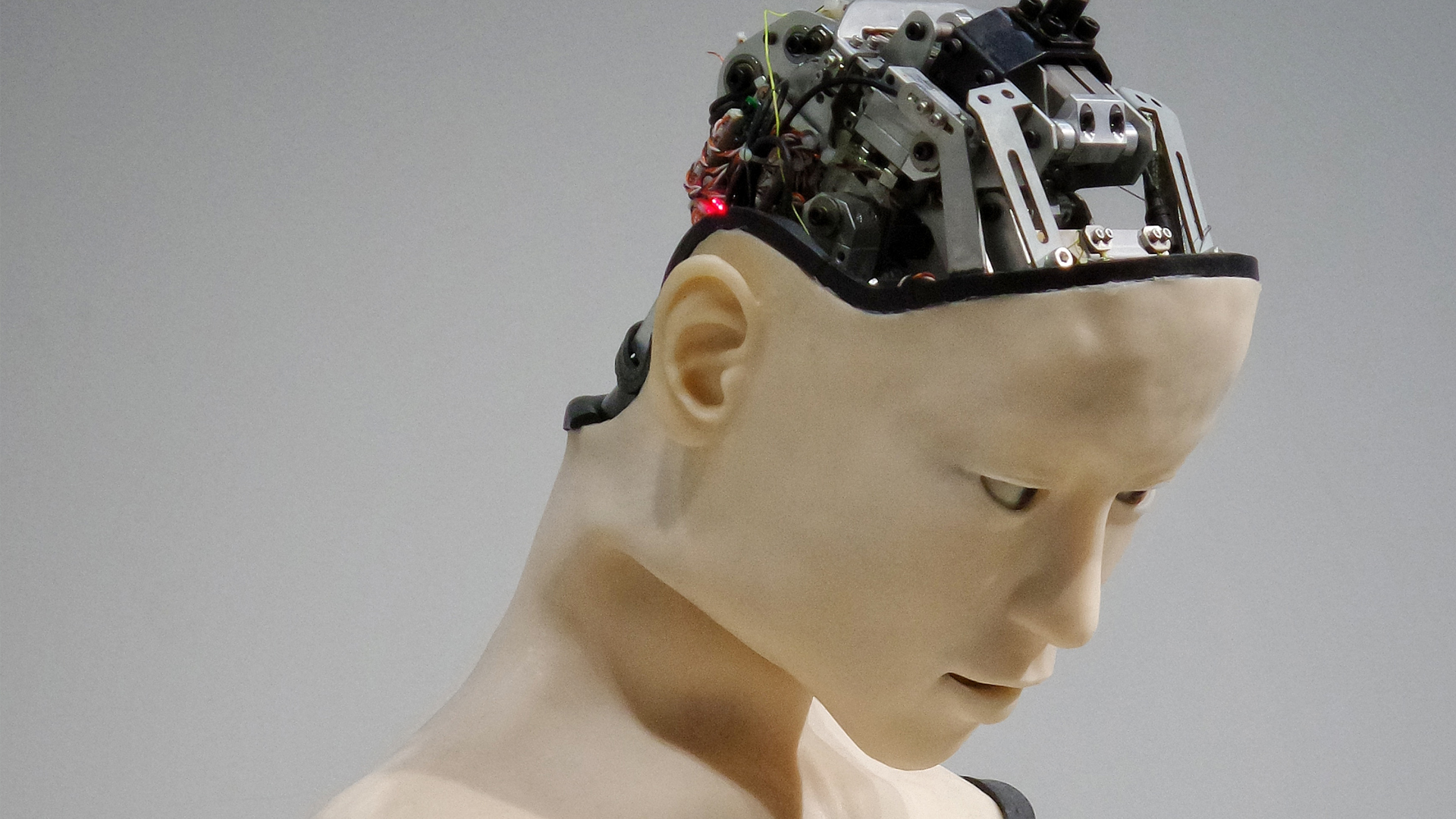

La inteligencia artificial (IA) ya no es asunto de ciencia ficción. Si bien las camareras robots no son todavía una realidad, los investigadores procuran arduamente crear máquinas capaces de razonar y resolver problemas, cuyos «cerebros» puedan rivalizar con los nuestros. ¿Deberíamos preocuparnos?

Mientras que por un lado Seán Ó hÉigeartaigh —anglicanizado como Sean O’Hegarty— se muestra entusiasta con respecto a las ventajas que la IA puede ofrecer, por el otro recela del lado oscuro de la tecnología. Habiendo obtenido su doctorado en genómica en Trinity College Dublin, ahora es director ejecutivo del Centro para el Estudio del Riesgo Existencial dependiente de la Universidad de Cambridge, ha desempeñado un rol fundamental en la investigación internacional en torno a los efectos y riesgos a largo plazo propios de la inteligencia artificial.

David Hulme, editor de Visión, conversó con él no solo sobre el estado actual de la tecnología, sino también hacia dónde apunta.

Seán Ó hÉigeartaigh, director ejecutivo del Centro para el Estudio del Riesgo Existencial dependiente de la Universidad de Cambridge

DH¿Cómo resumiría la historia de la IA?

SOHPodría considerarse que, como idea, la inteligencia artificial surgió en los años cincuenta. Algunas de esas ideas venían flotando desde antes, pero uno de los momentos realmente cruciales fue una conferencia celebrada en Dartmouth en 1956, durante la cual algunos de los pensadores más brillantes en ciencias informáticas y otros campos se reunieron y propusieron abocarse a la tarea de crear máquinas que pudieran pensar y razonar como humanos. Eran todos muy optimistas y ambiciosos. Pensaban que muchos de los problemas que a nosotros nos han llevado los sesenta años desde entonces se resolverían en el transcurso de un par de años, y que cosas como la visión artificial y la traducción automática serían difíciles pero no imposibles, con un equipo reducido en el transcurso de apenas unos meses.

Yo vería eso como el comienzo formal del campo de la inteligencia artificial.

DH¿Estamos progresando como pensábamos que lo haríamos, por aquel entonces?

SOHCreo que no como pensábamos, pero estamos progresando. Como en muchos campos científicos, crear inteligencia artificial ha resultado ser mucho más difícil que lo que en un principio parecía.

En retrospectiva, probablemente esto no sea de extrañar. La inteligencia es una de las cosas más complejas que existe. La idea de que pudiéramos recrear inteligencia o algo equivalente en el transcurso de apenas unos meses o años era por demás optimista. En los últimos sesenta años más o menos, ha habido ráfagas de progreso seguidas de una aparente desaceleración, descritas como veranos e inviernos de la inteligencia artificial. A menudo, un enfoque en particular ha dado fruto al principio, solo para después dejar de darlo.

Mucho del progreso logrado durante el transcurso de la última década se debe a un enfoque conocido como aprendizaje automático. Su singularidad reside en que los sistemas de aprendizaje automático no son de difícil programación para seguir una serie de medidas específicas. Más bien son capaces de analizar datos y bien adoptar una medida o dar una respuesta sin ser específicamente programados para esa tarea.

DHUsted se ha familiarizado tanto con el concepto del riesgo existencial como con la elaboración de la IA. Según señalara uno de sus colegas, Nick Bostrom, «la transición a la era de la inteligencia artificial parece un acontecimiento trascendental; uno que yo considero asociado con un importante riesgo existencial». Si eso es verdad, ¿cuál es el riesgo?, ¿y es existencial?

SOHEs importante notar que cuando Nick Bostrom habla sobre la transición a la inteligencia automática y el riesgo existencial no se está refiriendo a los sistemas de inteligencia artificial que hoy tenemos en el mundo, sino a lo que considera el advenimiento de lo que pudiera denominarse «inteligencia artificial general», el tipo de razonamiento general, la inteligencia para resolver problemas que nos permita dominar nuestro entorno del modo en que la especie humana lo hace. En la actualidad estamos muy lejos de ello, y no hay consenso entre los expertos acerca de cuánto tiempo nos llevará lograrlo. Pero es muy improbable que sea en menos de una década y, según algunos, podría tomar varias décadas. Sin embargo, si lo consiguiéramos, indudablemente cambiaría el mundo de más maneras de las que podemos imaginar.

«Si tuviéramos que crear una inteligencia equivalente o quizás incluso mayor que la nuestra, sería imprudente asumir que nos iría muy bien».

Hemos dañado nuestro propio hábitat mucho más que ninguna otra especie. Estamos eliminando especies a un ritmo trepidante; estamos cambiando nuestro clima de un modo que pudiera resultar insostenible para nuestro futuro. Si vamos a traer inteligencia al mundo —sea como herramienta nuestra o como entidades independientes— que nos permitirá cambiar el mundo aún más, necesitamos pensar muy cuidadosamente qué tipos de objetivos les daremos y qué grado de autonomía pudieran tener estos sistemas futuros, porque puede que nos resulte muy difícil dar marcha atrás al reloj.

Esta no es la IA que tenemos en el mundo hoy ni la que tendremos mañana o el año que viene. Pero creo que bien vale la pena pensar anticipadamente si ya estamos en esa trayectoria y las medidas que queremos adoptar.

DHEn el informe titulado The Malicious Use of Artificial Intelligence: Forecasting, Prevention, and Mitigation (El uso malicioso de la inteligencia artificial: pronóstico, prevención y mitigación), publicado en febrero de 2018, usted dice: «La inteligencia artificial es un modificador del juego. En este informe se imagina cómo podría ser el mundo en los próximos cinco a diez años». Señala, además: «Nuestro informe es un llamado a la acción, dirigido a las instituciones gubernamentales y a particulares de todo el mundo». Así las cosas, ¿cuál ha sido la reacción por parte de los gobiernos, las corporaciones y los particulares?

SOHDe hecho, la reacción ha sido muy positiva. Al principio nos preocupaba que la gente pudiera decir que esto era alarmismo, lo cual no era en absoluto nuestra intención. La idea era que todos los autores, muchos de los cuales participan en la elaboración de inteligencia artificial, se interesaran en detectar y mitigar los usos negativos potenciales, a fin de conseguir los usos positivos que a todos tanto nos entusiasman. Nos ha complacido ver que el informe fue reconocido en este sentido. Recibimos comentarios muy positivos y estamos en el proceso de organizar algunos cursos prácticos complementarios. Todos los autores del informe han recibido invitaciones para dar a conocer las conclusiones del informe. (Yo acabo de llegar de una reunión con expertos de la ONU, organizada por la Universidad de las Naciones Unidas).

Una de las principales recomendaciones que intentábamos dar es que —siendo que se está creando inteligencia artificial con bastante rapidez y se está aplicando a tantos diversos sistemas esenciales para la seguridad de nuestro mundo— necesitamos comenzar a colaborar más estrechamente entre expertos en aprendizaje automático que realmente entiendan la tecnología de vanguardia; formuladores de políticas y abogados que tengan que legislar al respecto y guiar la estrategia gubernamental; y miembros de la infraestructura civil y sociólogos dispuestos a pensar en cuanto al impacto de la IA. Nos interesaba especialmente detectar las formas en que la gente pudiera usar o adaptar para mal adelantos beneficiosos en materia de inteligencia artificial, para causar daños en diversas maneras, y cómo impedirlo.

DH¿Cuáles son las aplicaciones principales de la IA que deberían preocuparnos?

SOHObservamos en particular tres aspectos: el digital (lo que entendemos como, por ejemplo, ataque y defensa cibernéticos), el físico (maneras en que se podría atacar la infraestructura física) y el político (adelantos en materia de vigilancia, propaganda automatizada destinada a cualquier cosa que pudiera permitir a agentes maliciosos subvertir los procesos políticos o interferir en deliberaciones y debates veraces).

Identificamos tres tendencias generales comunes a estas áreas. Una de ellas, que la inteligencia artificial permitirá la expansión de las amenazas que actualmente enfrentamos; otra es que introducirá nuevos tipos de amenazas que requerirán nuevos enfoques para mitigarlas; y una tercera, que modificará de diversas maneras la naturaleza de las amenazas que enfrentamos.

Por dar un ejemplo de la expansión de amenazas: en la actualidad, en un atentado cibernético, hay una gran diferencia entre la efectividad de los llamados spear phishing y los phishing. Se trata de un phishing cuando alguien envía un mensaje electrónico malicioso para intentar que quien lo recibe clique en un enlace o active algo perjudicial. Si uno recibe un mensaje electrónico según el cual un príncipe nigeriano le ofrece cincuenta millones de dólares, lo más probable es que no lo crea y lo haga a un lado. En contraste, en un ataque spear-phishing participa una persona —o un grupo de personas— que tomará bastante tiempo para identificar a su destinatario como un objetivo cotizado, aprendiendo todo lo que pueda sobre él a fin de preparar un atentado personalizado que parezca convincente.

«Parece que proviene de alguien en quien uno confía o abarca suficiente información personal como para que no se note que se trata de un ataque malicioso. Estos son mucho más eficaces; aun los expertos informáticos y de seguridad los creerán».

En la actualidad hay límites en lo que respecta a cuántos de estos tipos de ataques eficaces se llevan a cabo, porque crearlos requiere mucho tiempo y conocimiento especializado; pero si alguien pudiera automatizar bastante del proceso, pronto sería accesible para muchos más agentes, y resultaría mucho más barato. Por ejemplo, digamos que un sistema automático le escanea e identifica como blanco cotizado, sea por la organización de la que usted forma parte o por su riqueza o patrones de actividad. El sistema podría entonces recabar mucho de su información personal, su perfil en las redes sociales y sus actividades, y luego, mediante la automatización de varios trozos del proceso, facilitar que usted se deje engañar por el ataque, bien al ayudar a crear un mensaje que muy probablemente usted cliquearía, o por la inclusión de trozos de información que le darían la impresión de que se trata de un mensaje electrónico importante para usted, o incluso a través de voces o imágenes sintetizadas. Estamos llegando al punto en el que alguien podría convertir un mensaje grabado en su propia voz, en algo que suene como la voz de alguien que uno conoce (esto si se tienen suficientes muestras de la voz de esa persona). Y así, de pronto uno cuenta con una caja de herramientas para permitir un ataque más sofisticado, que pudiera estar a disposición de mucha más gente que en el pasado.

En estos momentos solo un grupo sumamente bien dotado de recursos podría hacer algo como crear el gusano informático Stuxnet o acabar con la red energética de Ucrania. Pero, de nuevo, si muchos aspectos de lo que conforma un ataque altamente especializado, precisamente sincronizado y de recursos elevados se pueden automatizar, quizá sea posible que veamos más de estos tipos de ataques.

Los propios sistemas de inteligencia artificial pueden ser atacados de maneras diferentes de las utilizadas contra sistemas informáticos tradicionales. Muestra de ello es la idea de un ataque destinado a confundir, según el cual si uno coloca en el sistema el tipo de imagen o la clase de pixeles que corresponde, puede engañar al sistema haciéndole creer que está viendo lo que no está viendo. Se ha demostrado, por ejemplo, que si uno cambia tan solo un par de pixeles en una señal de pare que un vehículo autopilotado ve, este la lee como siga. Como es de imaginarse, hacer esto a gran escala provocaría no pocos accidentes. Ahora bien, yo pienso que los coches autopilotados tendrán suficientes ojos como para que —dado el citado contexto— nada de esto suceda. Pero si vamos a introducir estos sistemas en todo, desde la atención médica hasta el transporte y la infraestructura civil, tenemos que pensar en las nuevas maneras en las que estos sistemas pudieran verse atacados.

Otra muestra pudiera darse en el aspecto físico. En estos momentos no hay manera de que un ser humano pueda operar un enjambre de drones, tal como un enjambre de pequeños robots voladores. Pero la inteligencia artificial permitiría la coordinación y comunicación entre drones y, potencialmente, un ataque muy poderoso. Esa es un arma enteramente nueva que pudiera estar a disposición de la gente en los próximos cinco a diez años.

DHMartin Rees aborda el peligro de los riesgos existenciales causados por agentes incontrolados cuando dice su célebre frase: «La aldea global tendrá sus idiotas aldeanos». ¿Son estos los únicos individuos que usted trata de frenar?

SOHYo creo, realmente, que en lo que respecta a los agentes solitarios y los idiotas aldeanos tenemos que preocuparnos. Uno de los factores preocupantes al respecto es que los adelantos —tanto en materia de inteligencia artificial como de biotecnologías (y Martin ha escrito mucho acerca de esto)— podrían permitir que el lobo solitario haga más daños sofisticados y de más graves consecuencias de los que habría sido capaz de hacer en el pasado. Con todo, creo que probablemente sería ingenuo descartar agentes no estatales —e incluso agentes estatales— más poderosos. Hemos visto el año pasado que ciertos estados han intentado interferir en los procesos políticos de otros estados. No hemos superado la etapa de ver conflictos a gran escala y guerras, y pienso que esto tiene que preocuparnos. En un mundo en el que nos enfrentamos a las presiones del cambio climático, la migración a gran escala, la seguridad alimentaria y del agua, y el nexo entre los alimentos, el agua y la energía, creo que necesitamos preocuparnos en lo que respecta a lo que tanto los grupos de muy buenos recursos como los lobos solitarios pudieran hacer.

DH¿Qué nos dice la situación de los medios sociales y la propaganda electoral rusa acerca del elemento humano en el uso indebido de la IA? La información se puede usar para bien (con fines de comercialización) o para mal (con fines de manipulación).

SOHPienso que la manipulación rusa demuestra que hay muchas más formas de poder ser influenciados de las que necesariamente nos damos cuenta, y esto puede ocurrir aun a mayor escala. Es un presagio de lo que puede ocurrir si no pensamos cuidadosamente acerca de estas cosas. Así, por ejemplo, he leído que los piratas informáticos rusos enviaron unos diez mil tuits personalizados a miembros del Departamento de Defensa (de EE.UU) y otros. En estos momentos me imagino que fueron muchas las personas que escribieron esos tuits, pero, de nuevo, en caso de poder automatizar algunos de estos procesos, podríamos ver intentos de interferencia aún mayores, o esos instrumentos volviéndose al alcance de más gente. Necesitamos pensar cuidadosamente acerca de cómo habrán de usarse las tecnologías, porque ciertamente quienes están creando las técnicas que sustentan este tipo de automatización no lo hacen con el fin de facilitar el pirateo en las elecciones. Lo están haciendo para favorecer todo tipo de buenos propósitos a fin de reducir la carga de montones de cosas en las que perdemos el tiempo.

«Lo que realmente muestra es el uso potencial dual de muchas tecnologías; que nosotros podemos elaborarlas con solo propósitos beneficiosos en mente, pero necesitamos darnos cuenta de que hay gente que encontrará la manera de modificar su finalidad, lo cual no será necesariamente favorable».

DH¿De qué debería preocuparse la persona promedio en lo que respecta a la IA?

SOHCreo que la persona promedio debería pensar acerca del tipo de trabajo que hace, las destrezas necesarias para hacerlo, y si existe la probabilidad de que esas destrezas se puedan automatizar de aquí a diez o veinte años. Más aún, debería pensar acerca del tipo de educación que están recibiendo sus hijos, y si tal educación posibilita la flexible capacidad de resolver problemas de manera creativa que será crucial en un mundo en el cual se están abriendo nuevos trabajos, pero muchos de los sectores tradicionales de empleo se están desvaneciendo.

La persona promedio debería tener muy en cuenta su seguridad en línea, porque los tipos de ataques a los que podría estar expuesta van desde los más rudimentarios y fáciles de detectar hasta los más sofisticados y fáciles de hacerle caer.

La persona promedio también debería tener muy en cuenta las formas en las que la tecnología está posibilitando un mucho mayor acopio de información sobre ella, potencialmente influenciando sus acciones, sea por medio de agentes comerciales o por el estado. Como resultado, la persona promedio debería asegurarse de ejercer sus derechos democráticos y asegurarse de que los reglamentos y las políticas que se están promulgando en torno a estas tecnologías sean acordes con sus valores.

DH¿Qué significa el robo de identidad en este moderno mundo de la IA?

SOHEsa es una buena pregunta. En el pasado, ya nos habíamos familiarizado con la idea de los fraudes bancarios y con tarjetas de crédito. Ahora, en un mundo en el cual podemos crear un archivo de voz en el que parece que usted dice algo que yo escribí, pienso que bien podríamos ver formas de robo de identidad mucho más sofisticadas. Y dado que estamos viendo este ambiente de noticias falsas y de gente negando haber dicho lo que en verdad dijo, va a ser cada vez más difícil saber qué es real y qué es falso.

DHAsí las cosas, ¿qué impide que, de hecho, las máquinas tomen el control si algo sale mal; si —por ejemplo— la IA decide, tal vez, cortar el suministro eléctrico para preservar su propia integridad? ¿Tendrán aún, los humanos, poder para anular la mala decisión de la computadora?

SOHPor ahora, sí; y con «por ahora» me refiero a los años —y probablemente décadas— venideros. A corto plazo, lo más preocupante es la posibilidad de que no nos sea evidente que la máquina va por mal camino, sino hasta que sea demasiado tarde para intervenir sin provocar daños.

Se podría considerar como una versión temprana de esto la caída de la bolsa de 2010, en la que (entre otras cosas) tuvimos un mal funcionamiento de algoritmos en cascada, pero todo fue tan rápido que para cuando los humanos pudieron intervenir ya valores importantes habían desaparecido del mercado bursátil.

Necesitamos ser muy cuidadosos al introducir los sistemas de IA en más y más infraestructuras esenciales, y es fundamental que en todo momento procuremos entender cómo estos sistemas adoptan las decisiones que adoptan. ¿Cuáles son las circunstancias en las que tales sistemas funcionan bien? ¿Y cuáles, en las que fallarán?

No estamos ni por asomo cercanos al grado de tecnología que permitiría a los sistemas de IA exhibir mucho en materia de resolución de problemas de manera creativa en busca de sus objetivos, incluso en cuanto a tomar medidas para evitar que se desactiven, salvo en configuraciones de juegos muy simples. Así que, esto es motivo de preocupación para la comunidad de investigación a largo plazo, pero no, según creo, para impedirle el sueño a la persona promedio en estos momentos.

Continuar con la segunda parte.