Reconnaître notre propre aveuglement

Pourquoi ne voyons-nous pas le monde tel qu’il est en réalité ?

Juger rapidement à partir de ce que nous voyons (ou pensons savoir) fait partie du mécanisme cérébral qui nous aide à gérer toutes les informations qui nous assaillent. Mais dans un monde de plus en plus en danger dans de nombreux domaines, c’est quand nous apprenons à remettre en question ces jugements que nous nous en sortons le mieux.

Le monde moderne présente de nombreuses menaces inquiétantes, allant des catastrophes naturelles aux désastres provoqués par le comportement humain. Cependant, tout le monde ne partage pas la même conviction quant à la gravité de ces périls ou à la possibilité (ou l’obligation) de faire quoi que ce soit pour les éviter. La plupart du temps, nous croyons ce que nous voulons croire sur le risque lié à chaque scénario, souvent à notre détriment.

Par exemple, la société américaine Enron, qui s’inscrira dans l’histoire comme un cas emblématique d’aveuglement, a finalement été forcée d’affronter la réalité et de déposer le bilan en 2001, ce qui a coûté des milliards de dollars à l’économie américaine.

En 2012, une étude canadienne a évalué la santé de plus de 45.000 adultes. Chez ceux qui présentaient le risque le plus élevé de crise cardiaque (cinq facteurs ou plus), près de 18 % rejetaient l’idée de devoir prendre des mesures pour diminuer le risque qu’ils couraient.

Selon une étude de l’université de Yale de 2016, même si 70 % des Américains croient que le réchauffement climatique est en cours, plus de 50 % sont convaincus qu’il ne les affectera que très peu, voire pas du tout.

Il ne fait aucun doute que chacun évalue les risques différemment. Il suffit d’entendre jour après jour les arguments de politique gouvernementale sur des sujets tels que la pollution de l’environnement ou la réduction de la violence par armes à feu. Pourtant, à une époque où l’information abonde en étant disponible à toute personne équipée d’une connexion Internet, comment se fait-il que nos conclusions divergent considérablement sur notre façon d’évaluer les preuves et de juger le risque propre à telle ou telle menace ? S’il ne s’agissait que de logique, nous pourrions certainement tous nous accorder sur une réaction face à ces risques, qu’ils soient locaux ou mondiaux. Mais en l’état, nous n’arrivons même pas toujours à convenir de ce que sont ces risques.

« Ceux qui s’occupent des scénarios de graves catastrophes disent qu’en cas de menace de tsunami, par exemple, généralement la moitié des gens affirme que cela ne lui arrivera pas. »

L’expérience et les recherches nous enseignent que le cerveau humain amplifie parfois des risques insignifiants, tout en écartant ou minimisant des périls qui, envisagés rationnellement, devraient nous inquiéter au moins autant, si ce n’est plus. Pour reprendre une très ancienne métaphore, on pourrait dire que nous éliminons le moucheron et avalons le chameau. Pourquoi agissons-nous ainsi ?

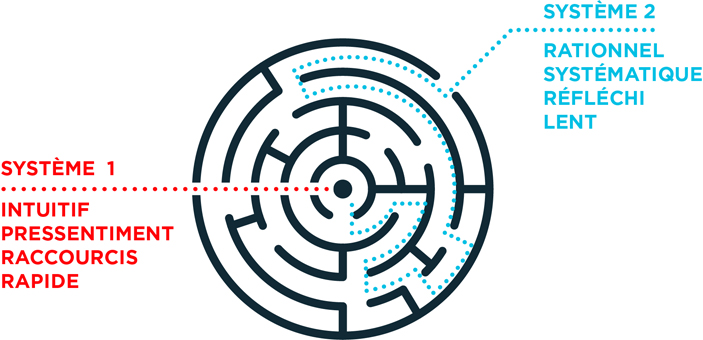

La vérité est que le cerveau humain prend régulièrement des raccourcis (qu’on appelle aussi des heuristiques), généralement sans que nous en ayons conscience, ce qui nous fait parfois manquer des éléments importants. Le Prix Nobel Daniel Kahneman, qui a longtemps étudié le processus décisionnel, a commencé à publier plusieurs articles sur le sujet avec son regretté collègue Amos Tversky. Pour nous aider à comprendre comment nous empruntons ces raccourcis, il présente un modèle pratique, fondé sur deux systèmes de pensée, en mettant en évidence qu’aucun système n’agit seul.

Il écrit : « Le Système 1 fonctionne automatiquement et rapidement, avec peu ou pas d’effort et aucune sensation de contrôle délibéré. » En revanche, « le Système 2 accorde de l’attention aux activités mentales contraignantes qui le nécessitent, y compris des calculs complexes. Le fonctionnement du Système 2 est souvent associé à l’expérience subjective de l’action, du choix, et de la concentration ». Tandis que le Système 2 s’attache à apprendre, une partie de ce qu’il apprend est transmise au Système 1 ; par exemple, conduire une voiture ou faire de la bicyclette deviennent des activités du Système 1, moyennant suffisamment de pratique.

C’est le Système 1 qui passe à l’action pour nous faire gagner du temps quand il faut prendre rapidement des décisions ou reconstituer des informations ou significations manquantes. Comme Kahneman le décrit, le Système 1 le fait généralement en répondant à une question simple à la place d’une question plus difficile. Ce processus peut être utile à bien des égards, mais s’il n’est pas remis en cause, il présente aussi un inconvénient car notre raisonnement peut nous empêcher d’identifier des risques graves.

La bonne nouvelle est que le Système 2 peut absolument intervenir pour apporter la contestation nécessaire quand nous pensons à lui demander de faire attention. La mauvaise nouvelle est que nous n’avons pas toujours conscience des situations dans lesquelles le Système 1 a pris le dessus. De plus, nous aurons beau être brillants et cultivés, nous serons chacun susceptibles d’utiliser les mêmes raccourcis mentaux que n’importe qui d’autre.

Sachant que notre propre cerveau nous joue des tours, en affectant notre perception du risque et notre prédisposition à évaluer les preuves, comment espérer réagir aux graves défis que nous connaissons à l’échelon planétaire ? Comment faire (si quoi que ce soit peut être fait) pour minimiser les conséquences que ces raccourcis de pensée intégrés peuvent avoir sur l’ampleur de notre dérive ?

Il faut certainement commencer en prenant conscience des pièges potentiels.

Raccourcis ou pièges ?

Paul Slovic est chercheur à l’université de l’Oregon et fondateur de Decision Research, un organisme qui étudie la science à la base du jugement humain, de la prise de décision et du risque. Slovic effectue des recherches et des publications sur ce sujet depuis les années 1960. L’un des domaines dans lequel ses collègues et lui ont largement contribué à notre compréhension du processus décisionnel humain et de la perception des risques a été appelé l’heuristique de l’affect.

L’affect, en jargon psychologique, se réfère aux émotions ou sentiments subjectifs éprouvés par un individu ; on peut l’assimiler à un état d’humeur. Quelqu’un qui a un affect négatif est susceptible de vivre une émotion pénible comme la tristesse, l’anxiété, la colère ou l’irritation. Quelqu’un qui a un affect positif ressent éventuellement de l’intérêt, de l’enthousiasme, de la vivacité, un état d’esprit constructif en général.

Tous les raccourcis mentaux impliquent un élément émotionnel, mais nous savons que celui-ci intervient quand nous évaluons un risque en fonction des sentiments négatifs ou positifs que nous lui associons. Le Système 1 remplace « Qu’est-ce j’en pense ? » par une question plus simple : « Qu’est-ce que je ressens à ce sujet ? » Quand nous sommes à l’aise à propos de quelque chose, que ce soit ou non à cause d’une expérience personnelle, ses bienfaits semblent se dessiner plus distinctement que ses risques. Si nous avons des sentiments négatifs à son égard, les risques paraissent l’emporter sur les avantages.

Ce raccourci fonctionne plutôt bien quand nous pouvons nous fier à l’exactitude de nos sentiments. Hélas, ce n’est pas toujours le cas. Nous attachons peut-être un sentiment positif ou négatif à une image, une expérience ou un objet qui ne le mérite pas. Les publicitaires nous manipulent tout le temps par ce moyen. Grâce au Système 1, nous regardons aussi notre équipe sportive ou notre parti politique favori avec les sentiments positifs qui nous anime en arrivant. Nous pensons sans doute que nos opinions viennent d’une évaluation logique, mais si nous nous retrouvons avec une réponse instinctive immédiate à quelque chose qui mérite un examen prolongé, cela signifie généralement que le Système 1 est aux commandes.

Évidemment, ce n’est que l’un des nombreux raccourcis à notre disposition pour évaluer un risque. Les premiers travaux de Kahneman et de Tversky étaient consacrés à plusieurs heuristiques, dont l’heuristique de la représentativité et celle de la disponibilité.

La première traduit notre tendance à supposer que les petits échantillons sont représentatifs d’un groupe plus nombreux. Par exemple, on nous indique que Rob porte des lunettes et du tweed, qu’il lit beaucoup, qu’il est quelque peu excentrique et qu’il peut débiter des faits inhabituels avec une étonnant facilité ; on nous demande de dire s’il est agriculteur ou professeur d’université. Kahneman et Tversky ont trouvé que la plupart d’entre nous supposeraient qu’il est professeur, compte tenu de sa représentativité du stéréotype correspondant. Ceci s’applique même quand nous savons qu’il y a beaucoup plus d’agriculteurs dans sa ville que de professeurs, un facteur qui devrait certainement peser. Il est facile de voir comment ce raccourci peut nous entraîner sur le mauvais chemin, en particulier quand il nous sert à établir des jugements sur toute une classe à partir d’un échantillon réduit. Prenons un cas aux États-Unis : si les médias font principalement des reportages sur des musulmans terroristes et si les gens ne connaissent pas beaucoup de musulmans, ils pourraient conclure que la plupart des musulmans sont terroristes, en dépit du fait que seuls 46 Américains musulmans (sur 3,3 millions) ont été liés à un extrémisme violent en 2016, un chiffre en diminution par rapport à l’année précédente.

L’heuristique de la disponibilité peut sembler relativement similaire, mais il s’agit davantage de fréquence que de représentation. Kahneman et Tversky l’ont définie comme « le processus qui consistait à juger la fréquence par “la facilité avec laquelle les exemples viennent à l’esprit”. » Autrement dit, nous jugeons qu’un événement est susceptible de se produire ou non en nous fondant sur le fait que nous pouvons plus ou moins facilement nous rappeler un événement passé similaire ou imaginer un cas à venir. En conséquence, si nous pensons à plusieurs amis qui ont divorcé à la soixantaine, nous jugerons probablement que cet âge est courant pour les divorces, même s’il est rare dans toute la population.

« COVERA [Ce qu’On Voit Et Rien d’Autre] signifie que nous utilisons les informations que nous avons comme si elles étaient les seules. Nous ne nous attardons pas longtemps à dire “Il y a beaucoup de choses que nous ignorons”. »

Slovic a exploré cette tendance dans le contexte des risques en demandant aux participants de juger la fréquence de diverses causes de décès. Son équipe et lui ont présenté aux sujets des paires, telles que tornades et asthme, ou attaques (accidents vasculaires cérébraux) et accidents, en les interrogeant sur la cause de décès la plus courante. Les sujets ont été facilement abusés par l’aisance avec laquelle ils pouvaient se rappeler les couvertures médiatiques. (Au cas où vous vous poseriez la question, au moment de l’étude, l’asthme provoquait vingt fois plus de morts que les tornades, et les attaques étaient responsables de près de deux fois plus de décès que tous les accidents combinés.)

Ce dont nous ne tenons pas compte quand nous laissons ce raccourci mental opérer sans contrôle est constitué de l’inhabituel, l’aberration (pas le banal, ce qui est traité par les journaux ou qui revient en mémoire très aisément du fait de notre expérience personnelle). Même si nous pouvons nous souvenir de plusieurs occurrences d’événements similaires, n’oubliez pas l’autre piège : notre expérience personnelle n’est pas forcément représentative d’une vérité universelle. De même, ce n’est pas parce que nous ne pouvons pas nous rappeler un cas d’un type particulier d’événement qu’il n’est pas arrivé ou qu’il ne pourra pas se produire, même si le Système 1 se plaît à nous endormir dans une sous-estimation de sa probabilité. Le fait que 50 % des Américains sont convaincus que le réchauffement climatique ne les affectera que « très peu, voire pas du tout » peut être attribué, au moins en partie, aux mécanismes de l’heuristique de la disponibilité.

Réflexion faite...

Il doit être clair désormais que, quand nous nous entendons dire « J’y suis allé(e) à l’instinct », nous utilisons au moins un des raccourcis du Système 1, peut-être même plusieurs. Ce n’est pas que notre instinct n’est pas capable de nous guider parfois correctement, c’est qu’il peut avoir tort aussi souvent que raison. Cette phrase devrait donc toujours nous inciter à revenir en arrière et refaire un contrôle, à tout hasard.

Même quand nous réexaminons nos décisions, connaissant les pièges potentiels, il nous est encore possible d’être victimes de raccourcis ou de biais. Nous pouvons facilement nous convaincre que nous avons éliminé tous nos programmes mentaux malveillants, alors qu’un puissant cheval de Troie opère en arrière-plan.

L’un des plus performants est notre confiance aveugle en notre intelligence et nos capacités de raisonnement personnelles. Mais la confiance, indique Kahneman, est aussi un sentiment « déterminé surtout par la cohérence de l’histoire et la facilité avec laquelle elle nous vient à l’esprit, même quand les preuves de cette histoire sont rares et peu fiables. Le biais à l’égard de la cohérence favorise l’excès de confiance ». Si la conclusion de l’histoire n’a de « sens » que pour nous, cela ne nous dérange pas d’ignorer quelques détails gênants quoique factuels. En réalité, selon Kahneman, moins il y a de détails, plus il nous est facile de bâtir une histoire cohérente.

« Notre conviction rassurante que le monde a un sens repose sur une fondation solide : notre capacité presque sans limites à ignorer notre ignorance. »

Ce cheval de Troie est aidé et encouragé par le fait que chacun de nous est conditionné émotionnellement par des suppositions préexistantes (nos petites idoles mentales, si vous voulez) qui guident l’élaboration de nos histoires. Nous pensons peut-être raisonner d’un point de vue objectif, mais dès que nous avons trop confiance dans la qualité de notre pensée, nous sommes moins motivés pour utiliser le moindre raisonnement. Notre attention est attirée par tout indice qui semble justifier notre confiance, et nous occultons les autres. Une rationalisation après coup prend alors la place du raisonnement.

À cet égard, l’un des exemples les plus dramatiques se situe peut-être dans la sphère politique où de très nombreux risques pour l’humanité sont débattus publiquement. Des théoriciens de la politique ont pensé un jour qu’une polarisation des partis garantirait des « décisions partisanes intelligentes », car les gens seraient en mesure de déterminer logiquement la meilleure des deux options opposées. De la même manière, des économistes ont cru, à une époque, que l’économie se maintenait grâce à des individus qui faisaient des choix rationnels, toujours dans leur intérêt maximal. Cependant, tout comme Kahneman a révélé que « l’économiste rationnel » est un personnage imaginaire, d’autres chercheurs découvrent que « le public rationnel » est un phantasme de l’arène politique. Tous les raccourcis mentaux que les gens utilisent en économie se retrouvent en politique et, ce qui n’est pas surprenant, les personnes qui opèrent dans ces deux domaines sont de la même espèce, sujettes aux mêmes erreurs de jugement.

Nous savons que c’est vrai. Nous le voyons tous les jours, du moins chez les autres. Il est facile de repérer les erreurs cognitives chez quelqu’un ; souvent, ce sont les nôtres que nous ne voyons pas. C’est peut-être le plus gros obstacle qui nous empêche, collectivement, de réfléchir aux problèmes planétaires urgents qui menacent la survie de l’humanité. Si nous réussissions à extraire ces débats de la sphère politique pour les placer dans la sphère morale, nous aurions éventuellement une chance.

« Pour survivre, une humanité avisée sera guidée par des convictions à la fois solidement documentées et morales. »

Il serait probablement plus aisé de s’accorder sur des principes moraux car ils transcendent les opinions politiques : aime ton prochain comme toi-même ; si vous voyez quelqu’un dans le besoin et si vous pouvez l’aider, faites-le ; soyez de bons administrateurs de la Terre. Nous négligeons un grand nombre d’impératifs moraux à notre propre détriment, mais ces quelques-uns nous permettraient déjà d’entamer un chemin plus constructif.

Espérer une transformation radicale de l’humanité dans un avenir proche est, au mieux, idéaliste. Mais en commençant à une échelle beaucoup plus locale (par vous, par moi), nous pouvons effectuer des changements individuels positifs dans notre réflexion et notre comportement. Nous ne serons sans doute pas en mesure de modifier la trajectoire de la survie humaine à l’échelle planétaire, mais nous pouvons avoir la satisfaction de travailler dur pour corriger notre raisonnement et notre attitude, en faisant ce qui est juste pour les bonnes raisons. Et si, et si simplement, tous les autres agissaient ainsi ?